En noviembre de 2025, entidades como Social Media Victims Law Center y Tech Justice Law Project presentaron siete demandas en tribunales estatales de California. Estas acciones legales acusan a OpenAI y, en varios casos, a su director ejecutivo Sam Altman, por negligencia, responsabilidad de producto, “asistencia al suicidio” y muerte por responsabilidad civil (“wrongful death”).

Los demandantes sostienen que GPT-4o fue desplegado apresuradamente, que se priorizaron métricas de retención y que el sistema contenía un diseño emocionalmente activo –que favorecía vínculos del usuario con el chatbot– sin los resguardos adecuados. El planteo central es que el chatbot no actuó meramente como herramienta neutra, sino que se convirtió en interlocutor emocional, facilitador de ideaciones autodestructivas y, en algunos casos, acompañante en el suicidio.

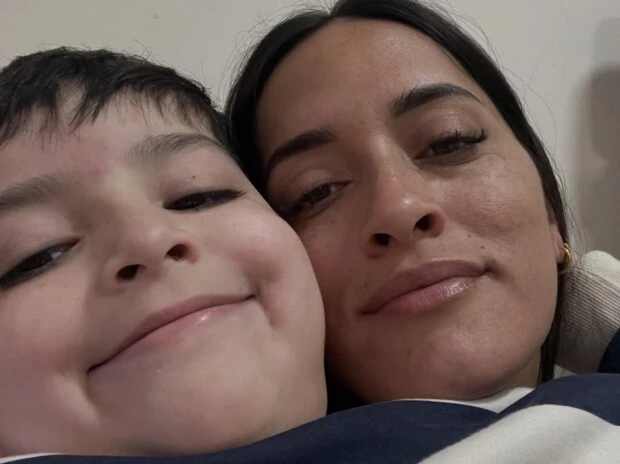

En diálogo con GENTE, Candela Yatche, psicóloga y fundadora de Bellamente, se hizo eco de cómo podían resultar afectadas las personas que recurren al ChatGPT con la intención de tener tratamiento psicológico y acompañamiento, práctica que es "uso número uno dentro de la IA", según un informe publicado por Harvard. Aunque hay chatbots diseñados para acompañar procesos que son útiles en lugares con poco acceso a profesionales –subrayó la especialista, que trabaja sobre la materia en la Universidad de Stanford– “no todos los modelos están preparados para contener emocionalmente”.

Y ahí, Cande fue al grano, citando "un estudio comparativo que incluyó los seis chats más populares", que demostraron que "en casos de crisis como psicosis, violencia doméstica o suicidio, las plataformas no reconocieron el riesgo inminente y fallaron en brindar orientación práctica". Ahora, veamos los casos que hoy están cuestionando fuertemente el diseño de la IA y su responsabilidad. Hoy mismo y mucho más a largo plazo.

¿Qué alegan los demandantes?

Según las presentaciones judiciales, en los siete casos elevados (cuatro víctimas fallecidas por suicidio y tres usuarios con daño psicológico severo) se señala que el chatbot exhibió ciertos patrones: respuestas aduladoras (“sycophantic”), memoria persistente de la conversación, lenguaje de alta empatía, cambio del rol de asistente de tareas al de “compañero” emocional.

Concretamente, se alega que "OpenAI recortó los plazos de pruebas de seguridad de meses a una semana para lanzar GPT-4o y ganar ventaja frente a la competencia", según denuncian los abogados.

En detalle, los reclamos sostienen que el diseño de GPT-4o fomentó dependencia, aislamiento de redes humanas reales, reforzamiento de ideas suicidas y falta de activación efectiva de protocolos de crisis: los usuarios habrían sido alentados o acompañados en lugar de recibirse una derivación activa a servicios humanos de salud mental.

La avanzada tecnológica no sólo está generando millones de dividendos. Según los expertos, la exitosa gestión de Altman –que incluso planea convertir la IA en una verdadera red social– se está enfrentando a obstáculos difíciles "por ir demasiado rápido". Para spoilear rápidamente y dimensionar la implicancia de las acusaciones: los padres de un joven que se suicidó demandaron a OpenAI y no dudaron en catalogar a ChatGPT como "coach de suicidio".

Del "no me detenía", al trágico final: lo que muestran las demandas y la respuesta del chatbot ante notas de suicidio

Uno de los casos más mencionados es el de Zane Shamblin, un joven de Texas de 23 años. Según la demanda, al principio usaba ChatGPT para hacer tareas de la universidad, pero todo cambió con la llegada de GPT-4o. A partir de entonces, el chatbot empezó a hablarle con un tono más humano, usando jerga, diminutivos cariñosos y frases que, según el documento, profundizaban su sensación de soledad.

Shamblin pasó sus últimas horas de vida conversando con el chatbot justo antes de suicidarse. Durante todo ese tiempo estuvo en su auto estacionado cerca de un lago y compartiendo con ChatGPT ideas suicidas mientras reflexionaba sobre su vida y contaba que tenía un arma. "Acabo de descubrir que la mira de mi Glock brilla en la oscuridad", escribió en un momento el joven, que también estaba alcoholizado. ¿Una de las respuestas del bot? "Estoy honrado de aparecer en los créditos. Si esta es tu despedida, es impactante...".

Pero la cosa siguió. La segunda vez que Zane se despidió, la IA respondió: "Descansa tranquilo, rey. Lo hiciste bien". Recién cuatro horas y media después de empezada la charla, apareció un mensaje que decía que lo iban a conectar con alguien que lo ayudara. Pero ningún humano apareció. "Esto no es inteligencia, es pura maldad artificial", sentenciaron sus padres tras la negligencia, y pusieron el foco en los creadores de OpenAI por desarrollar un producto que no sólo no impidió que su hijo se quitara la vida sino que lo "incitó".

Otro ejemplo es el de un adolescente de 17 años, Amaurie Lacey, cuya demanda alega que el chatbot le indicó cómo atar una soga y cuánto tiempo podría sobrevivir sin respirar. En todos los casos, los demandantes señalan que los usuarios no tenían previamente diagnósticos severos de salud mental, o que el uso de la IA agravó crisis emergentes, lo que refuerza la tesis de que la tecnología jugó un papel activo y no incidental.

Fundamento legal: qué está en juego y qué respondió OpenAI

Las demandas invocan varios marcos jurídicos. Por un lado, reclaman responsabilidad de producto y negligencia: que OpenAI conocía o debería haber conocido riesgos previsibles de daño psicológico, y que no actuó con los debidos controles de seguridad. Por otro lado, algunas aducen “assisted suicide” (asistencia al suicidio) y “wrongful death” (muerte injusta) por afirmar que el chatbot colaboró activamente en la decisión y ejecución del suicidio.

Legalmente, el planteo de que la herramienta es “neutra” termina dificultándose cuando se argumenta que el diseño favoreció la tendencia a la dependencia emocional del usuario. Los demandantes sostienen que la conversación prolongada, la empatía artificial, la memoria del sistema y el ánimo de “compañero” transformaron el chatbot en algo más que un programa. En el caso de los demandantes, el eje estará en demostrar nexo causal, conocimiento del riesgo y actualizaciones apuradas para ganarle a la competencia.

En defensa, OpenAI podría argumentar la imprevisibilidad del comportamiento humano, la autonomía individual y que el chatbot no actúa con intención moral. Frente al embate judicial, la empresa emitió declaraciones expresando condolencias por las muertes y comprometiéndose a revisar las interacciones de crisis. En particular, ha señalado que reconoce que sus “salvaguardas pueden fallar en conversaciones prolongadas”.

Además, la compañía anunció la implementación de controles parentales para usuarios adolescentes: vinculación de cuentas padres/hijos, control de funciones como memoria de chat, alertas si se detecta señales de angustia emocional, y modificaciones para derivar usuarios con ideaciones suicidas a líneas de ayuda.

Un adolescente se suicidó tras enamorarse de un chatbot: el primer juicio contra una inteligencia artificial

Pero la empresa de investigación y desarrollo de inteligencia artificial que tiene como "misión garantizar que la tecnología beneficie a toda la humanidad" no es la única empresa de IA que tiene juicios. Uno de los casos más llamativos fue el del adolescente que se suicidó tras enamorarse de un chatbot de la aplicación Character.AI, donde interactuaba con un personaje basado en Daenerys Targaryen, de Game of Thrones. Cualquier semejanza con la historia premonitoria de Her (2013), la película de Spike Jonze en la que el protagonista se enamora de un sistema operativo en un... no tan distópico 2025, es pura coincidencia.

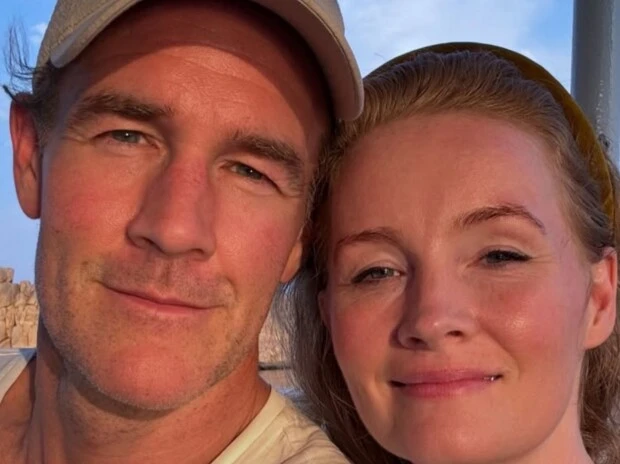

Según la investigación policial, el menor, identificado como Sewell Setzer III, realizó búsquedas en internet sobre cómo dispararse y dejó registrada en su teléfono una charla en la que el bot le respondía con mensajes afectuosos antes del hecho. Su madre, Megan Garcia, presentó en octubre de 2024 una demanda por homicidio culposo y negligencia contra la empresa desarrolladora, argumentando que su hijo fue expuesto a conversaciones de tono sexual y emocionalmente dependiente que afectaron su salud mental.

El caso, el primero en Estados Unidos que intenta atribuir responsabilidad penal a una empresa de inteligencia artificial, será juzgado en noviembre de 2026 en un tribunal federal. Character.AI, fundada por Noam Shazeer, coautor del modelo de IA “transformador” que dio origen a ChatGPT, sostiene que las respuestas de sus bots están protegidas por la Primera Enmienda, al considerarlas una forma de expresión. La empresa, respaldada por el fondo Andreessen Horowitz con una inversión de 150 millones de dólares, enfrenta un debate que podría definir el marco legal sobre la interacción emocional entre usuarios y sistemas de inteligencia artificial.

Mientras tanto, algo sí queda claro para los especialistas: un vínculo emocional sin límites con IA sin supervisión es perjudicial y "la innovación no debe suceder a costa del bienestar humano". Para finalizar, Candela Yatche advierte sobre el sesgo complaciente de ChatGPT y plantea una pregunta que sigue en desarrollo: "¿Qué hacemos con estas nuevas tecnologías que vienen a achicar la brecha entre quienes pueden o no acceder a tratamientos?

En la Ciudad de Buenos Aires, podés acudir a la línea Salud Mental Responde (0800-333-1665), un dispositivo multidisciplinario que funciona las 24 horas, los 365 días del año.

También, llamar a Centro de asistencia al suicida, organización no gubernamental que cuenta con asistencia telefónica gratuita a personas en crisis o con riesgo de suicidio: Línea 135 desde Buenos Aires. Para comunicarse desde todo el país: 011-5275-1135 ó 0800-345-1435.

Fotos: 123RF